Cómo predecir mejor nuestro futuro: La importancia del pensamiento bayesiano en nuestras vidas

Este principio estadístico no solo mejora la precisión en campos como la inteligencia artificial, sino que también nos ayuda a gestionar la incertidumbre en nuestra vida personal y profesional.

La idea de «predecir el futuro» suele evocar imágenes de adivinos con bolas de cristal o misteriosas cartas de tarot. Pero en realidad, todos hacemos predicciones cada día sin necesidad de herramientas sobrenaturales. Desde anticipar cómo será una persona conocida cuando se reúna con nosotros hasta suponer que el sol iluminará el cielo al amanecer, nuestras vidas están llenas de pronósticos basados en experiencias pasadas. Sin embargo, las herramientas que usamos para estas predicciones cotidianas pueden no ser suficientes cuando nos enfrentamos a decisiones más complejas o inciertas. Por ejemplo:

¿Cómo interpretamos los resultados de una prueba médica? ¿O cómo decidimos qué tratamiento médico seguir ante diagnósticos contradictorios?

Ante una crisis de salud pública, como una pandemia, ¿cómo podemos usar la información que surge cada día para ajustar nuestras acciones y expectativas?

¿Cómo podemos evaluar los riesgos y los beneficios de un nuevo cambio de carrera o de trabajo usando los conocimientos previos y las nuevas oportunidades que se nos presentan?

¿Cómo puede un buen enfoque ayudarnos a decidir sobre la educación de nuestros hijos en un mundo de constantes cambios tecnológicos y culturales?

¿Cómo mantenemos y ajustamos nuestras relaciones personales a medida que evolucionan o se enfrentan a problemas?

En el contexto de las redes sociales y la información masiva, ¿cómo podemos filtrar la información ruidosa y formarnos una opinión más informada sobre cuestiones controvertidas?

¿Cómo podríamos aplicar el razonamiento para decidir medidas de sostenibilidad individuales o comunitarias en respuesta a los informes sobre el cambio climático?

¿Cómo podemos aplicar un buen enfoque para mejorar nuestra capacidad de medir y predecir el clima y cómo aplicamos ese mismo enfoque para ajustar nuestros planes y actividades diarias ante los nuevos datos meteorológicos?

Aquí es donde entra en juego el teorema de Bayes.

En este ensayo ofrezco una introducción rápida y práctica al teorema de Bayes, su impacto en nuestras vidas, en la ciencia y en la historia, cómo funciona y por qué es tan útil para tomar decisiones en situaciones de incertidumbre. Basándonos principalmente en el libro de Tom Chivers, Everything Is Predictable, exploraremos cómo empleamos las probabilidades cada día, los frecuentes errores que cometemos al interpretarlas, por qué el teorema de Bayes es crucial en ámbitos como la medicina, el derecho y la inteligencia artificial y cómo podemos «predecir» mejor el futuro.

INTRODUCCIÓN

El teorema de Bayes no es solo una fórmula matemática. Es también una herramienta para tomar decisiones informadas en un mundo lleno de incertidumbres. Comprender este teorema puede cambiar nuestra forma de predecir y entender los acontecimientos que nos rodean.

Este principio matemático se centra en la probabilidad condicional, es decir, evalúa cómo cambia la probabilidad de un acontecimiento a medida que se obtiene nueva información. Imaginemos que estamos jugando a las cartas y ya sabemos que la primera carta que sacamos no es un corazón. Automáticamente, las probabilidades de que la siguiente carta sea un corazón aumentan ligeramente. Este tipo de razonamiento es crucial en juegos de estrategia como el póquer y el dominó.

El razonamiento bayesiano no solo nos ayuda a «predecir» el futuro, sino también a ajustarnos mejor al presente. Tom Chivers sugiere en su obra que nuestros cerebros funcionan de forma bayesiana inconscientemente. Ajustamos constantemente y sin cesar nuestra interpretación del mundo basándonos en nuevos datos. Si caminamos por un callejón oscuro y vemos una sombra, nuestro primer pensamiento podría ser que se trata de una persona, influidos por nuestras experiencias e información anteriores. Sin embargo, al acercarnos y descubrir que se trata solo de una silla, corregimos inmediatamente nuestra percepción. Este ajuste es un proceso automático y constante.

Incluso nuestra experiencia consciente puede verse como una cadena de predicciones que nuestro cerebro realiza basándose en la información recibida. Estamos actualizando perpetuamente nuestras creencias sobre la realidad, de forma similar a como funcionaría un algoritmo bayesiano. Según Chivers, este fenómeno explica por qué existen grandes desacuerdos sobre temas ampliamente debatidos como el cambio climático o las vacunas, ya que nuestras creencias previas moldean la forma en que interpretamos la nueva información.

El teorema de Bayes nos permite comprender mejor los desacuerdos y explorar por qué es tan complicado cambiar las opiniones de alguien. Pero antes de adentrarnos en tales cuestiones, empecemos por ver qué es el teorema de Bayes.

¿QUÉ ES EL TEOREMA DE BAYES?

El teorema de Bayes es una fórmula matemática que nos permite actualizar nuestras creencias basándonos en nueva información o evidencias. En términos sencillos, nos ayuda a responder: «¿qué probabilidad hay de que algo sea cierto, dado que hemos observado ciertas evidencias?».

Para los curiosos, la ecuación se presenta así:

Expliquemos brevemente sus componentes:

P(A|B) es la probabilidad de que ocurra el evento A, dado que ha ocurrido el evento b.

P(B|A) es la probabilidad de que ocurra B, dado que ha ocurrido A.

P(A) es la probabilidad inicial (a priori) de que ocurra A.

P(B) es la probabilidad inicial de que ocurra B.

Aunque a primera vista esta ecuación pueda parecer compleja, la idea que la sustenta es sencilla. Cuando nos llega nueva información, debemos ajustar lo que ya creíamos para tomar decisiones más acertadas.

El teorema de Bayes no emergió del vacío. Sus raíces se encuentran en la vida y las inquietudes intelectuales de Thomas Bayes, quien, impulsado por su curiosidad científica y su disidente entorno intelectual, transformó el concepto de probabilidad en una herramienta lógica para hacer frente a la incertidumbre. Este viaje, que condujo a Bayes desde los principios del cálculo hasta la formulación de una nueva visión de la probabilidad, será el centro de nuestra próxima exploración.

BREVE HISTORIA DE THOMAS BAYES Y EL DESARROLLO DE SU RAZONAMIENTO

Thomas Bayes (1702-1761), el padre de este teorema, fue ministro presbiteriano en una época y un lugar donde ser un disidente religioso en Inglaterra acarreaba grandes problemas y marcaba a quienes elegían ese camino. Comprender su contexto es clave para entender su vida y su obra. En los siglos XVII y XVIII, la Iglesia de Inglaterra dominaba el panorama religioso, exigiendo el uso exclusivo del Libro de Oración Común. Sin embargo, la segunda Ley de Uniformidad de 1662 reforzó esta norma tras un breve periodo de libertad, expulsando a unos dos mil clérigos que se negaron a conformarse. Estos religiosos fueron llamados ministros «no conformistas» o «disidentes». Estos clérigos, privados de sus púlpitos, encontraron refugio como capellanes en casas de familias nobles simpatizantes o establecieron sus propias casas y academias disidentes en 1689, gracias a una nueva ley de tolerancia.

Entre las diversas ramas de la disidencia, que incluían a presbiterianos, congregacionalistas, bautistas y cuáqueros, los presbiterianos se distinguían por su estructura organizativa y su rigor teológico, que heredaron del movimiento puritano. Bayes, que procedía de una familia de disidentes de Sheffield, estaba muy arraigado en esta comunidad. Su bisabuelo, Richard Bayes, un hombre acomodado de la industria cuchillera, y su abuelo Samuel, educado en prestigiosas universidades, establecieron un legado de resistencia y pensamiento crítico. A pesar de ser expulsado de su parroquia por no adherirse a la uniformidad, Samuel continuó su labor en Manchester, mientras que Joshua, su otro hijo y padre de Thomas, fortaleció la comunidad disidente de Sheffield con la fundación de una capilla.

Joshua Bayes fue un pionero en su época, siendo uno de los primeros presbiterianos ordenados públicamente en Londres tras estudiar en una academia disidente del norte de Inglaterra. Se ganó un respeto considerable como predicador y erudito. El joven Thomas, el mayor de sus siete hijos con Anne Carpenter, creció en un hogar lleno de vigor intelectual y estabilidad económica, beneficiándose de la considerable fortuna familiar que Joshua distribuyó a partes iguales entre sus hijos a su muerte en 1746.

A Thomas Bayes se le cerraron las puertas de Oxford y Cambridge por su estatus de disidente, lo que le llevó a matricularse en la Universidad de Edimburgo en 1719. Allí se sumergió en estudios de filosofía, lógica y matemáticas, y aunque no hay registros directos de su tutela temprana, se cree que se hizo amigo de John Ward, un erudito amigo de su padre que le dio lecciones de latín y griego, preparándole para su educación superior. Durante su estancia en Edimburgo, Bayes también estudió con James Gregory, un respetado matemático, y recibió clases de historia.

Además de su labor religiosa, Bayes tenía un gran interés por la ciencia. Le interesaba especialmente la filosofía natural de Newton, a la que estuvo expuesto durante su formación en Edimburgo bajo la tutela de Gregory. Su pasión por Newton le llevó incluso a financiar la publicación de trabajos que divulgaban las teorías del célebre científico, lo que subraya su compromiso con la difusión del conocimiento científico.

En 1734, el filósofo George Berkeley lanzó un mordaz ataque contra los fundamentos del cálculo diferencial, la doctrina de los flujos de Newton, criticando el uso de incrementos que «desaparecían» como una contradicción lógica. Thomas Bayes, defensor acérrimo de Newton, respondió en 1736 con la publicación de «An Introduction to the Doctrine of Fluxions and a Defense of the Mathematicians Against the Objections of the Author of the Analyst» («Introducción a la doctrina de los flujos y defensa de los matemáticos contra las objeciones del autor del análisis»). En este ensayo, Bayes no solo defendía a Newton, sino que también intentaba proporcionar una base más rigurosa para los flujos, anticipándose a conceptos posteriores de límites matemáticos como el que desarrollaría Cauchy, un matemático francés que realizó grandes contribuciones al cálculo y al análisis matemático, sentando las bases de muchas teorías modernas en estas áreas. (A pesar de sus esfuerzos, la claridad de Bayes fue cuestionada por algunos historiadores, que señalaron que no había resuelto el problema central planteado por Berkeley).

Bayes también exploró las series infinitas, trabajando en la derivación correcta de la aproximación de Stirling para factoriales grandes, esencial para estimar los valores de los factores. Sus notas incluyen desarrollos anteriores incluso al trabajo de Lagrange, físico y matemático, en 1772, como la derivación de la fórmula de suma de Euler-Maclaurin, una herramienta matemática que conecta sumas y cálculos integrales, ayudándonos a aproximar la suma de una serie con integrales para facilitar cálculos complejos.

Todo este interés estadístico le condujo a la probabilidad. Su interés por la probabilidad se centró en una pregunta novedosa: ¿qué nos dicen los datos observados sobre una hipótesis concreta? Es decir, no calculaba la probabilidad de que ocurriera un suceso dada una hipótesis fija, sino la probabilidad de que esa hipótesis fuera cierta dado el suceso observado. Su ensayo, «An Essay toward Solving a Problem in the Doctrine of Chances» (Un ensayo para resolver un problema en la doctrina de las probabilidades), introduce este enfoque denominado «probabilidad inversa». Su famoso ejemplo de la mesa en la que ruedan bolas —un ejemplo al que nos referiremos en breve— ilustra cómo podemos estimar la posición de una línea desconocida dividiendo el plano en dos, basándonos en observaciones aleatorias de bolas en los dos lados.

El interés de Bayes por la probabilidad parece haber sido estimulado por su época y sus contemporáneos. Mientras que algunos especulan con que se vio influido por Abraham de Moivre, un matemático francés, otros sugieren que dirigió su atención a este campo tras analizar un artículo de Thomas Simpson. Inventor y matemático inglés, Simpson había argumentado que la media de múltiples observaciones era un estimador más preciso que una observación aislada. Bayes, sin embargo, cuestionó esta afirmación, argumentando que los errores sistemáticos en las mediciones no podían compensarse simplemente aumentando el número de observaciones, mostrando así una comprensión crítica de la estadística y sus limitaciones.

Además de sus investigaciones sobre la probabilidad y las series infinitas, Thomas Bayes fue un hombre de grandes intereses científicos. Su cuaderno personal revela apuntes que van desde la trigonometría a la geometría pasando por las ecuaciones diferenciales, y también profundizó en campos como la electricidad, la óptica y la música. No solo se dedicó a la investigación, sino que también fue un crítico activo dentro de la comunidad matemática de su época. A través de sus comentarios sobre el trabajo de colegas como Simpson y en correspondencia con otros científicos de renombre como Philip Stanhope y Patrick Murdoch, Bayes se estableció como una figura central en el diálogo matemático.

Bayes murió en 1761. Sin embargo, su legado quedó definitivamente cimentado tras su muerte. Su amigo Richard Price, otro ministro no conformista, filósofo moral y matemático, publicó póstumamente el ensayo sobre la probabilidad, una obra revolucionaria que presentaba un método para estimar la probabilidad de sucesos desconocidos basándose en observaciones previas. Este ensayo formuló lo que hoy conocemos como «teorema de Bayes». Price amplió el ensayo, sugiriendo aplicaciones y argumentando que el teorema podía demostrar la regularidad y consistencia de las leyes naturales, que para él eran una prueba de la existencia de Dios. En este contexto, el teorema de Bayes sirvió para contradecir la opinión del filósofo David Hume sobre los milagros. Hume sostenía que era imposible probar la existencia de los milagros a partir de testimonios, ya que las leyes de la naturaleza eran más fiables que los testimonios humanos. Para Price, la regularidad era una cuestión probabilística, no de certeza absoluta, lo que dejaba espacio para sucesos raros e incluso milagrosos.

La publicación de este ensayo elevó el trabajo de Bayes al estatus de leyenda, situándolo como uno de los pilares de la estadística moderna y marcando un antes y un después en la forma en que entendemos la incertidumbre y la toma de decisiones basada en datos.

UN GRAN LEGADO

Así, Bayes nos legó una idea filosófica tan importante como su ecuación. Según su punto de vista, la probabilidad no es una característica inherente del mundo o del universo, sino una medida de nuestra propia incertidumbre, una expresión de lo que no sabemos.1 Para ver esto con más claridad, imaginemos una situación cotidiana: lanzar una moneda al aire. La probabilidad a priori de que salga cara es del 50%. Esta cifra no refleja una propiedad inherente a la moneda, sino nuestra falta de información. Dado que la moneda tiene dos lados, y en ausencia de otra información, suponemos que cada lado tiene la misma probabilidad de salir.

Así pues, la probabilidad es en cierta medida subjetiva, moldeada por nuestras creencias y suposiciones previas sobre la realidad. Más adelante profundizaremos sobre los problemas de esta idea. Por ahora toca decir que aunque la probabilidad es subjetiva, esto no significa aleatoriedad ni que cualquier probabilidad a priori sea igualmente válida. Algunas suposiciones iniciales pueden ser mejores que otras si se basan en razones sólidas. Con el tiempo y a medida que actualizamos nuestras creencias con nuevas evidencias, nuestras probabilidades tienden a ajustarse más a la realidad, lo que demuestra que el proceso bayesiano conduce a aproximaciones más exactas.

La clave del método de Bayes era el uso de probabilidades previas: una suposición inicial de cómo creemos que son las cosas antes de obtener nueva información. Es decir, nuestras creencias iniciales deben influir en cómo interpretamos la información. Por ejemplo, si un mago nos muestra una moneda, podemos sospechar que está trucada. Esta sospecha, o probabilidad previa, afectará a nuestra interpretación de los resultados de lanzar esa moneda.

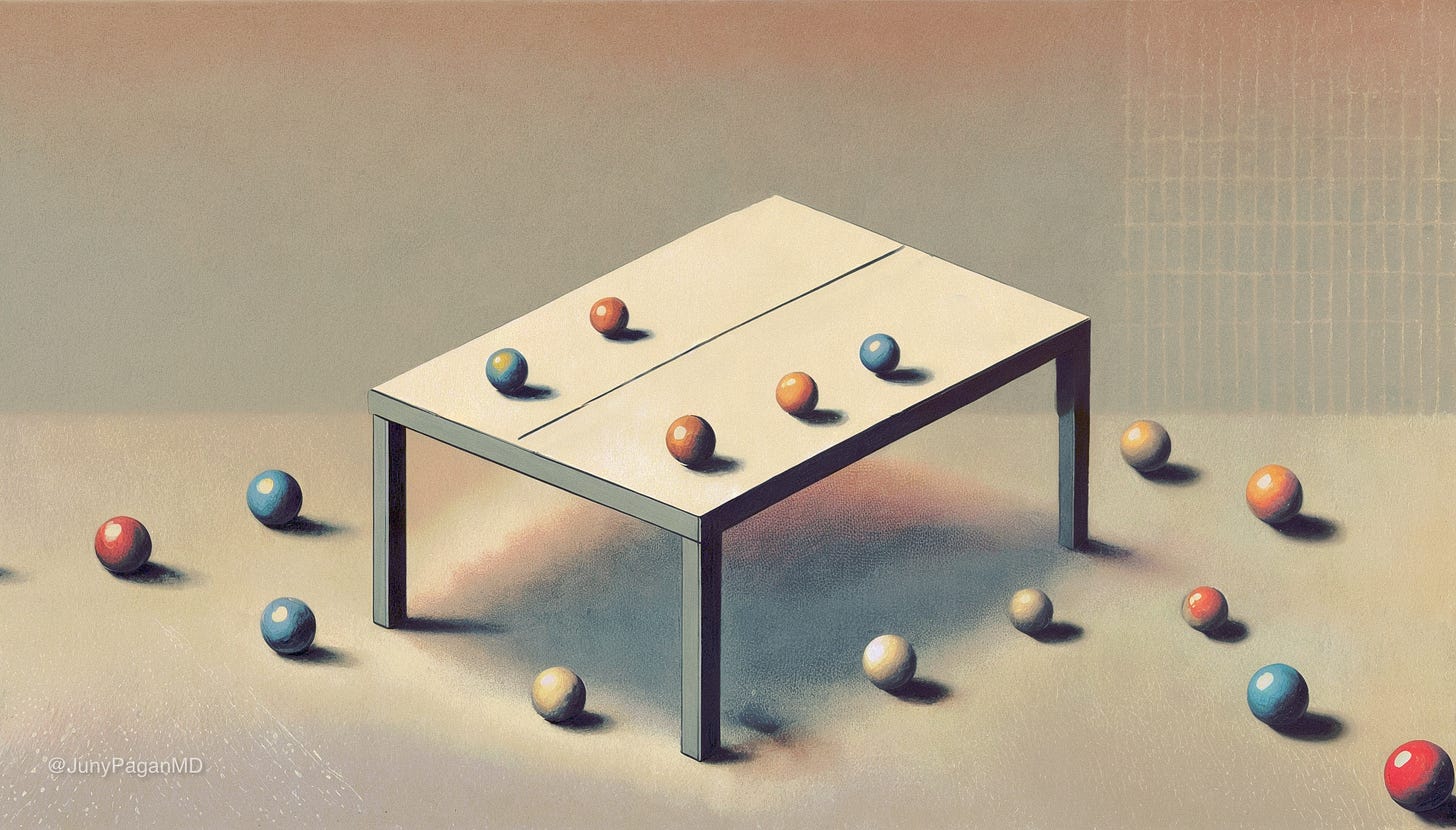

Bayes proponía ajustar continuamente nuestra estimación en función de los datos. Usó una metáfora interesante. Nos pide que imaginemos un experimento con una mesa oculta sobre la que lanzamos cinco bolas que caen al azar. Se nos informa de que una línea divide la mesa en un lado izquierdo y otro derecho, pero se desconoce su ubicación exacta. Después de lanzar las bolas, solo sabemos que dos bolas cayeron a la izquierda y tres a la derecha.

Inicialmente, antes de lanzar las bolas y sin más información, suponemos que la línea podría estar en cualquier lugar de la mesa con igual probabilidad. Entonces, interpretando los resultados directamente y sin ajustes, podríamos concluir que la línea se inclina hacia el lado izquierdo, en una proporción de dos quintos (2/5), lo que sugiere que esta zona es más pequeña y, por tanto, menos probable que las bolas caigan allí. Sin embargo, esta conclusión puede ser precipitada. Con solo cinco bolas, es probable que la distribución no refleje con exactitud la posición real de la línea, lo que podría llevarnos a sobrestimar o subestimar su ubicación basándonos en una muestra limitada.

Para manejar esta incertidumbre inicial y evitar conclusiones precipitadas, Bayes sugirió un ajuste metodológico: que añadiéramos una bola extra al número del lado izquierdo (2+1) y dos bolas al total lanzado (5+2). Al añadir una bola al lado izquierdo, dicho ajuste representaría nuestra creencia inicial de que la línea podría estar en cualquier parte y, por tanto, existe una probabilidad básica de que las bolas caigan en el lado izquierdo. Por otro lado, añadir dos bolas al total lanzado equilibraría el ajuste, reflejando nuestra incertidumbre inicial en ambos lados.

Tras aplicar el ajuste propuesto por Bayes, procedemos a calcular la probabilidad revisada:

Bolas del lado izquierdo: 2 observadas + 1 añadida por el ajuste = 3 bolas.

Total bolas: 5 observadas + 2 añadidas por el ajuste = 7 bolas.

Por tanto, la probabilidad ajustada es de 3/7. (La probabilidad ajustada de que una bola caiga hacia la izquierda es entonces del 43%).

¿Por qué tiene sentido este método? En primer lugar, refleja nuestra incertidumbre inicial al incorporar bolas imaginarias, reconociendo que cualquier posición de la línea era posible antes de cualquier observación. En segundo lugar, minimiza la dependencia de una muestra limitada. Con solo unos pocos lanzamientos, los resultados pueden variar significativamente por azar. Este ajuste proporciona un cálculo más equilibrado. En tercer lugar, en lugar de basarse únicamente en los datos observados, que sugerirían una probabilidad del 40% (2/5), este ajuste conduce a una estimación más moderada y matizada que combina nuestras observaciones con nuestras suposiciones iniciales.

Si no han entendido este ajuste, veámoslo en un escenario más familiar. No es perfectamente análogo, pero nos dará una idea. Imaginemos que estamos en una fiesta y nos encontramos ante una gran bolsa opaca llena de gominolas de varios sabores. Nos gustan especialmente las gominolas de fresa y nos preguntamos cuál será su proporción dentro de la bolsa, pero no tenemos ni idea de cuántos sabores hay ni de cómo están distribuidos. Así que, mientras la gente a nuestro alrededor baila y se divierte, nosotros nos ponemos a hacer cuentas con nuestras gominolas favoritas.

Una. Dos. Tres. Cuatro. Cinco. Al meter la mano en la bolsa cinco veces y seleccionar una sola gominola al azar cada vez, descubrimos que dos son de fresa y tres de otros sabores. Inicialmente, podríamos concluir que el 40% de las gominolas son de fresa (dos de cada cinco, como las bolas que cayeron a la izquierda de la línea), basándonos en esta pequeña muestra. Sin embargo, reconocemos que se trata de una muestra muy limitada y, antes de empezar, no teníamos información que nos indicara la distribución de los sabores.

Para manejar esta incertidumbre y ajustar nuestras observaciones, decidimos emplear el ajuste de Bayes. Añadimos una gominola imaginaria de fresa a nuestro recuento, reflejando nuestra creencia inicial de que cualquier gominola podía ser de fresa. Además, añadimos dos gominolas imaginarias al total muestreado, equilibrando nuestro ajuste para reconocer la presencia de otros sabores.

Tras aplicar el ajuste propuesto por Bayes, volvemos a calcular nuestros recuentos:

Gominolas con sabor a fresa: 2 observadas + 1 añadida por el ajuste = 3.

Total de gominolas muestreadas: 5 observadas + 2 añadidas por el ajuste = 7.

Por tanto, la probabilidad ajustada es de aproximadamente un 43% (o 3/7) de gominolas de fresa. En lugar de simplemente especular, esto nos da una base más sólida si decidimos seguir buscando gominolas de fresa en la bolsa… en lugar de ir a socializar con la gente.2

La idea de este ajuste es que debemos añadir cualquier información nueva con la información que ya tenemos. En nuestro caso, seguimos sin saber exactamente dónde está la línea (o cuál es el porcentaje real de gominolas; de hecho, podríamos haber sacado las dos únicas gominolas de fresa que había en la bolsa) debido a la poca información que aún tenemos. Pero es un buen comienzo. El método mejora nuestra estimación al permitirnos no sobrepasar los datos limitados y proporcionar una mayor precisión con menos información. También mejora al incorporar nuestras creencias previas con lo que hemos observado. Esto conduce a resultados más fiables y estables, menos susceptibles a los errores causados por muestras pequeñas. Al ajustarse, nuestras estimaciones se vuelven más sólidas y reflejan una imagen más exacta de la realidad observada.

Bayes también introdujo la idea de las distribuciones de probabilidad. En nuestra metáfora de las bolas y la línea, no solo es importante determinar la ubicación más probable de la línea, sino también evaluar la probabilidad de que la línea esté cerca de ese punto o más lejos. Cada vez que lanzamos bolas y recopilamos nueva información, ajustamos esta distribución, afinando nuestra predicción pero sin alcanzar nunca la certeza absoluta.

Antes hemos mencionado que, para Bayes, la probabilidad es una medida de nuestra incertidumbre, una perspectiva un tanto subjetiva que depende de nuestras creencias y suposiciones sobre lo que consideramos cierto. Este punto de vista ha desencadenado intensos debates en la comunidad científica, enfrentando a quienes adoptan el enfoque bayesiano, que hace hincapié en la importancia de las creencias previas, con los frecuentistas, que se centran en la frecuencia de los eventos. Este debate no es solo académico. Es casi una guerra entre dos escuelas de pensamiento sobre cómo interpretamos y usamos la probabilidad.

BAYESIANOS VS FRECUENTISTAS

A pesar de las importantes contribuciones de Bayes y Laplace, muchos estadísticos y científicos prefieren el enfoque frecuentista al bayesiano.

¿Qué es el frecuentismo?

La estadística frecuentista analiza los datos a través de la lente de la probabilidad de muestreo. Este método trata de determinar la probabilidad de observar determinados resultados suponiendo que una hipótesis específica sea cierta. El enfoque se centra principalmente en evaluar la probabilidad de obtener un resultado bajo una hipótesis nula, que generalmente sostiene que no existe ningún efecto o relación significativa.

Chivers nos proporciona un ejemplo claro para comprender este concepto. Supongamos que queremos investigar si las personas con pies grandes tienen un coeficiente intelectual (CI) superior a la media. Recopilamos datos de cincuenta individuos con una talla de zapato estadounidense trece o superior, y descubrimos que su CI medio es de 103, en comparación con un CI medio de 100 en la población general. Dado que nuestra muestra es relativamente pequeña, es importante considerar si este ligero aumento del CI podría haber surgido por pura casualidad. Aquí es donde entra en juego la estadística frecuentista. Suponemos que no existe relación entre el tamaño del pie y el CI (hipótesis nula) y calculamos la probabilidad de obtener un resultado tan extremo como el observado si la hipótesis nula fuera cierta. Este cálculo nos da el valor p.

Este valor p representa la probabilidad de observar resultados al menos tan extremos como los obtenidos, en el supuesto de que la hipótesis nula sea cierta. Por ejemplo, un valor p de 0,16 indica que, suponiendo que no exista relación entre el tamaño del pie y el CI, hay un 16% de probabilidades de observar una diferencia tan significativa o mayor simplemente por azar.

Entonces, ¿qué hacemos con este valor p? Ronald Fisher, un científico y estadístico eminentemente influyente, propuso establecer un umbral arbitrario, conocido como alfa, para determinar si rechazamos la hipótesis nula. Un umbral común es 0,05, lo que significa que si el valor p es inferior a 0,05, consideramos los resultados lo suficientemente improbables como para descartar la hipótesis nula y suponer que existe un efecto real. En nuestro ejemplo del tamaño de los pies y el cociente intelectual, como nuestro valor p es de 0,16, no alcanza el umbral para rechazar la hipótesis nula.

La lógica que subyace a este umbral es que, si el experimento se repite varias veces y realmente no hay ningún efecto, solo en el 5% de esas repeticiones observaríamos un resultado tan extremo como para justificar el rechazo de la hipótesis nula.

Diferencia entre el bayesianismo y el frecuentismo

El bayesianismo y el frecuentismo son dos escuelas de pensamiento opuestas en la teoría de la probabilidad, cada una con una interpretación diferente de lo que significa la probabilidad en sí.

El teorema de Bayes calcula la probabilidad de una hipótesis basándose en los datos observados, ajustando nuestra percepción a medida que llega nueva información. En este enfoque, la probabilidad se considera una medida de nuestra incertidumbre o falta de conocimiento sobre un acontecimiento concreto. Si carecemos de información sobre qué resultado es más probable, el principio bayesiano sugiere que debemos considerar todos los resultados como igualmente probables. Este punto de vista ha sido objeto de críticas, como veremos más adelante.

Por otro lado, el frecuentismo concibe la probabilidad como una medida objetiva, basada en la frecuencia con la que se observan los sucesos en la práctica. Esta perspectiva, defendida por figuras destacadas como John Stuart Mill, John Venn y Fisher, sostiene que la probabilidad de que una moneda justa salga cara es del 50% porque, teóricamente, en un número infinito de lanzamientos, saldrá cara la mitad de las veces. O, según Fisher, decir que la probabilidad de obtener un cinco en el lanzamiento de un dado es de una sexta parte no significa que de cada seis lanzamientos uno será un cinco. Más bien implica que, en un número infinito de lanzamientos, aproximadamente una sexta parte dará como resultado un cinco.

Así pues, una de las diferencias fundamentales entre los enfoques bayesiano y frecuentista de la estadística reside en su interpretación de la probabilidad. Los bayesianos se centran en la probabilidad inversa y los frecuentistas en la probabilidad de muestreo. Los estadísticos bayesianos observan los datos y se preguntan: «con la información de que dispongo, ¿qué probabilidad hay de que esta hipótesis sea cierta?». Usan los datos para modificar su confianza en una hipótesis. En cambio, los frecuentistas abordan el problema a partir de la hipótesis y evalúan la probabilidad de observar determinados datos si esa hipótesis es correcta, sin intentar calcular la probabilidad de la hipótesis en sí: «con la hipótesis de que dispongo, ¿qué probabilidad hay de que vea estos datos?».

Priores: qué son y por qué generaron debate

Como vimos, en el corazón del enfoque bayesiano hay un concepto de probabilidades previas, o «priores», que son esenciales para entender cómo los bayesianos abordan la probabilidad. Un prior es, básicamente, la creencia inicial sobre la validez de una hipótesis antes de que se recolecte cualquier evidencia nueva. Como ya sabemos, este nivel de confianza se basa en el conocimiento previo y se ajusta a medida que se acumulan nuevos datos, refinando así nuestra certeza sobre la hipótesis en cuestión.

Sin embargo, la subjetividad inherente a los priores ha sido un punto de controversia considerable. Estos valores iniciales pueden variar de manera significativa de un analista a otro, dependiendo de su experiencia y conocimientos previos, lo que significa que diferentes expertos podrían asignar diferentes probabilidades a la misma hipótesis antes de ver cualquier dato. Por ejemplo, si no conocemos el tamaño de un cuadrado, podríamos suponer que cualquier longitud de lado es igualmente probable, o que cualquier área es igualmente probable, lo que nos llevaría a conclusiones divergentes.

Esta subjetividad fue motivo de crítica por parte de estadísticos como Fisher y otros frecuentistas, para quienes la estadística debía ser una disciplina objetiva, fundamentada únicamente en datos observables y replicables. El hecho de que los priores bayesianos permitieran variaciones según el juicio individual parecía socavar la fiabilidad del método para los frecuentistas, abriendo la puerta a interpretaciones sesgadas.

El debate subrayó una cuestión importante: ¿puede considerarse científica una metodología cuyas conclusiones puedan ser influenciadas por opiniones personales previas? Este interrogante continúa siendo un punto de discución y debate acalorante y divisivo en la comunidad estadística.

El frecuentismo, al ser el enfoque más tradicional, ha perdurado en parte a estos problemas. Esta incomodidad con la subjetividad ha alimentado la prevalencia del frecuentismo, que favorece el uso de datos observables y resultados que no dependen de las suposiciones previas de los investigadores. La ciencia aspira a obtener resultados independientes de las creencias individuales, y el elemento subjetivo del bayesianismo entra en conflicto con esta expectativa. El frecuentismo garantiza que los análisis sean mucho más objetivos y universalmente reconocibles, una característica vital para su aceptación en la comunidad científica global.

Víctimas probabilísticas

Durante décadas, el frecuentismo, respaldado por figuras como Fisher, quien veía al teorema de Bayes como un grave error, se estableció como el enfoque predominante de la estadística, dejando a los bayesianos sintiéndose marginados en un entorno que a menudo rechazaba sus ideas. Algunos estudiosos bayesianos se enfrentaron incluso a la resistencia dentro de sus propios departamentos. Esta rivalidad llegó a ser tan intensa que los bayesianos llegaron a organizar conferencias anuales en las que, entre cánticos y bromas, defendían su metodología a la vez que satirizaban a los frecuentistas. Una canción dice:

Mis ojos han visto la gloria del reverendo Thomas Bayes.

Está acabando con frecuentistas y sus maneras incoherentes.

Ha levantado su gran ejército en el Hotel Las Fuentes.

¡Sus tropas avanzan ya!

Gloria, gloria, probabilidad!

Gloria, gloria, subjetividad!

Gloria, gloria hasta la eternidad!

¡Sus tropas avanzan ya!

En otra canción, los bayesianos imitan una canción famosa:

Verso 1:

Imagina que eres Bayesiano,

es fácil si te esfuerzas,

adoptas un «a priori»,

y los datos actualizan π.

La estadística es sencilla

con probabilidad subjetivaaaaa – ah-ah! ah ah...

Verso 2:

Ahora imagina ser frecuentista,

preocupándote por lo que pudo ser,

pasando toda tu vida

analizando datos que no logras ver.

Y si quieres un intervalo,

necesitarás una cantidad pivotaaaaaal – ah-ah! ah ah...

John Lennon se habría sentido orgulloso. La lucha entre estos dos bandos también se extendió a Internet, donde las discusiones entre los dos bandos se convirtieron en debates muy acalorados. Esta controversia llegó a tal punto que incluso el popular webcómic XKCD hizo comentarios al respecto, provocando nuevas discusiones y llevando a algunos a comentar que hablar de la diferencia entre bayesianos y frecuentistas podría ser más controvertido que discutir sobre israelíes y palestinos.

Ahora bien, aunque el bayesianismo fue y es muy criticado por su dependencia de las probabilidades a priori, hoy en día existen enfoques que tratan de minimizar esta subjetividad, especialmente en áreas como la inteligencia artificial. En los entornos modernos, los algoritmos de aprendizaje automático usan grandes cantidades de datos para ajustar estas probabilidades iniciales, haciendo que los resultados dependan menos de las suposiciones individuales y más de los patrones observados en la realidad. Este ajuste constante en respuesta a los datos permite que los modelos bayesianos sean cada vez más precisos y estén menos influidos por la subjetividad, al tiempo que conservan la flexibilidad para incorporar nueva información, una de sus mayores ventajas.

Así, el bayesianismo no solo sobrevivió, sino que se adaptó y evolucionó, introduciendo innovaciones (como las «priores de nivel superior» y el enfoque de Ramsey, que veremos más adelante) que tratan de reducir la subjetividad y gestionar las incertidumbres sobre qué priores usar. Este resurgimiento bayesiano ha provocado una vuelta de tuerca. Como dice Julia Galef, ahora son los frecuentistas los que sienten que su enfoque está siendo infravalorado y marginado, lo que marca un nuevo capítulo en esta prolongada guerra estadística.

Esta tensión entre bayesianos y frecuentistas refleja dos formas opuestas de afrontar la incertidumbre y procesar la evidencia, cada una con sus ventajas. Pero mientras que los frecuentistas buscan respuestas en datos repetibles, el bayesianismo ha demostrado su fuerza al permitirnos ajustar nuestras hipótesis, nuestras creencias y nuestras decisiones incluso en escenarios complejos. Esta adaptabilidad ha forjado un camino, dejando un impacto en la historia.

IMPACTO BAYESIANO EN LA CIENCIA Y EN EL MUNDO

El bayesianismo ha dejado una gran huella en la estadística y más allá, gracias a su capacidad para manejar la probabilidad condicional y actualizar las creencias a medida que surgen nuevos datos, una ventaja clave en situaciones en las que los datos son limitados o inciertos.

Harold Jeffreys y el primer bayesianismo científico

Harold Jeffreys (1891-1989), geólogo de Cambridge, fue uno de los más ardientes defensores del bayesianismo y pionero en la aplicación formal del teorema de Bayes en la investigación científica. Su enfoque fue revolucionario, especialmente dada la naturaleza opaca y altamente incierta de los datos con los que trabajaba. A diferencia de Ronald Fisher, que disfrutaba de la precisión de los entornos controlados en sus experimentos con guisantes y ratones, Jeffreys se enfrentaba a la imprevisibilidad de fenómenos naturales cargados de ruido como los terremotos. En este contexto, la estadística de Fisher, que dependía de la repetibilidad y la significación estadística de los datos, resultaba poco útil.

Jeffreys aplicó su filosofía a su trabajo. Comprendió bien que la ciencia rara vez nos da certezas absolutas. Más bien, la ciencia nos guía desde la oscuridad de la ignorancia hacia grados de claridad de conocimiento más prácticos y aplicables. Para Jeffreys, la ciencia no consistía en alcanzar una certeza inmediata, sino en reducir gradualmente nuestro grado de ignorancia, un proceso que describió como pasar de la «ignorancia total» a la «certeza práctica». Según él, construimos el conocimiento mediante la acumulación progresiva de evidencias, donde la incertidumbre es una parte inevitable de la investigación científica y su aspecto más fascinante.

Jeffreys veía la probabilidad no solo como un método para analizar datos, sino también como una herramienta necesaria para expresar y gestionar la incertidumbre a cualquier nivel de hipótesis científica. Incluso cuando se enfrentaba a dudas sobre la validez de una ley científica, Jeffreys estaba dispuesto a cuantificar su confianza en términos probabilísticos. Este enfoque se consideró revolucionario en su momento y desafiaba directamente la noción frecuentista de que la probabilidad solo debía aplicarse a sucesos repetibles y al análisis de datos empíricos concretos.

Jeffreys encontró en el enfoque bayesiano una herramienta inestimable. Usaba la información de la llegada de ondas sísmicas a diferentes estaciones para deducir tanto el epicentro del terremoto como la composición de los materiales atravesados por esas ondas. Cada evento sísmico iba acompañado de una incertidumbre considerable, debido a la naturaleza aleatoria de los terremotos y a la irregularidad de los datos. Su método requería una actualización constante de sus hipótesis en función de la nueva información que recibía, algo esencial en el bayesianismo.

Gracias a esta estrategia, Jeffreys logró importantes avances. En 1926, por ejemplo, fue el primero en demostrar que el núcleo de la Tierra es líquido, una revelación que transformó nuestra comprensión del planeta. Además, determinó que la corteza terrestre es principalmente silícea, mientras que el núcleo se compone sobre todo de hierro y níquel. Esta capacidad de manejar la ambigüedad de los datos geológicos con el enfoque bayesiano fue crucial para estas conclusiones, y ofreció perspectivas que los métodos frecuentistas simplemente no podían proporcionar.

Para Jeffreys, la probabilidad era aplicable a cualquier grado de incertidumbre, lo que le permitió aplicar probabilísticamente creencias sobre fenómenos únicos, como la naturaleza del núcleo de la Tierra -líquido o sólido-, abriendo así nuevos caminos para la ciencia actual.

Jeffreys contra Fisher

Tanto Jeffreys como Fisher fueron contemporáneos en el mundo de la estadística y mantuvieron una relación curiosa. Aunque discrepaban duramente, sentían un profundo respeto el uno por el otro. Fisher, que era un firme defensor de la estadística frecuentista, se centraba en la significación estadística (recordemos: el valor p) y en la hipótesis nula, cuestionando hasta qué punto era probable observar datos si suponíamos que no había ningún efecto. Por su parte, Jeffreys argumentó que este enfoque no era adecuado para muchos problemas científicos, ya que no permitía una evaluación directa de las hipótesis alternativas ni una actualización continua de la confianza en ellas.

Tal intercambio entre Jeffreys y Fisher puso de manifiesto las limitaciones del frecuentismo a la hora de abordar problemas científicos complejos y manejar datos muy inciertos. Aunque en aquel momento el frecuentismo era el enfoque dominante, Jeffreys sentó unas bases conceptuales sólidas para la adopción de los métodos bayesianos en la ciencia. Gracias a su enfoque y a su voluntad de abordar la incertidumbre y revisarla a la luz de la nueva información, el bayesianismo acabó ganando terreno y fue redescubierto por la comunidad científica décadas después.

El enfoque de Ramsey y las apuestas

En los albores del siglo XX, el dilema de los priores subjetivos en estadística supuso un reto para los pensadores a la hora de encontrar soluciones innovadoras. Frank Ramsey (1903-1930), un destacado matemático y filósofo inglés de las décadas de 1920 y 1930, abordó este problema desde un ángulo inesperado: la lógica de las apuestas. Ramsey sugirió que nuestras creencias son en realidad decisiones que reflejan apuestas sobre la realidad. Por ejemplo, cuando decidimos salir de casa para coger un tren, estamos apostando a que el tren llegará y nos permitirá alcanzar nuestro destino a tiempo. Si no creyéramos razonablemente en esta posibilidad, no correríamos el riesgo.

Ramsey propuso que estas creencias podían cuantificarse usando este marco de apuestas. Si creemos que la probabilidad de que se produzca un acontecimiento es de 1/3, es como decir que estamos dispuestos a aceptar una apuesta que nos paga dos a uno si el acontecimiento se produce. De este modo, Ramsey abordó la subjetividad de las probabilidades a priori proponiendo que pueden estructurarse de forma coherente y racional.

El enfoque de Ramsay ofreció una nueva forma de ver los priores e introdujo conceptos fundamentales como la utilidad esperada, que calcula el valor medio de los posibles resultados ponderado por su probabilidad, y la teoría de la decisión, que es el estudio de cómo tomamos decisiones racionales evaluando opciones y consecuencias para elegir la mejor acción posible en situaciones de incertidumbre. Estas ideas revolucionaron posteriormente campos tan diversos como la economía y la psicología —campos con mucho ruido y datos inciertos— al considerar cómo tomamos decisiones en situaciones de incertidumbre. Este legado de Ramsey continúa influyendo en cómo entendemos y medimos nuestras expectativas y decisiones ante la incertidumbre.

Alan Turing: el bayesianismo en la Segunda Guerra Mundial

Durante la Segunda Guerra Mundial, el bayesianismo no solo se aplicó en la teoría, sino que también desempeñó un papel importante en la práctica. Alan Turing (1912-1954) trabajó en Bletchley Park, el epicentro del descifrado de códigos en el Reino Unido. Turing se enfrentó a la difícil tarea de descifrar los códigos de la máquina Enigma, usada por los submarinos alemanes para enviar mensajes crípticos. Dado el enorme número de combinaciones posibles generadas por Enigma, buscar todas las posibilidades era un ejercicio inútil.

Turing recurrió al enfoque bayesiano para abordar este enorme desafío. Basándose en suposiciones previas, como la mayor probabilidad de ciertas secuencias de letras alemanas —por ejemplo, «EIN» (uno en alemán) frente a secuencias poco probables como «JXQ»-, Turing y su equipo pudieron reducir significativamente el número de combinaciones viables y concentrarse en las más prometedoras.

Además, Turing desarrolló una medida bayesiana conocida como «ban» para cuantificar la cantidad de información adquirida con cada descifrado, una técnica precursora de los actuales bits de información. Integrando las hipótesis previas y ajustando las probabilidades con cada nuevo dato, el equipo de Turing consiguió descifrar los códigos Enigma, una hazaña que salvó innumerables vidas y aceleró el final de la guerra.

La aplicación práctica del bayesianismo por parte de Turing mostró su utilidad en situaciones complejas de gran presión y validó el poder de usar priores en el análisis de problemas críticos, redefiniendo lo que era posible en el campo de la criptografía y la inteligencia militar.

Impacto más allá

Veremos más ejemplos más adelante, pero por ahora cabe decir que durante la Segunda Guerra Mundial y más allá, el bayesianismo encontró aplicaciones prácticas en una gran variedad de disciplinas. En el campo de los seguros, los actuarios usaron el teorema de Bayes para ajustar las primas de riesgo laboral basándose en datos históricos de accidentes y reclamaciones. En el campo del control de calidad militar, los inspectores usaron los principios bayesianos para reducir la cantidad de pruebas necesarias en las municiones, optimizando los recursos en tiempos de guerra. Incluso en artillería, los mandos usaban este enfoque para calcular la trayectoria óptima de los disparos, teniendo en cuenta las probabilidades implicadas.

A pesar de su probada eficacia, el bayesianismo no fue plenamente aceptado en los círculos académicos hasta la década de 1970, en parte debido a la resistencia de figuras como Fisher, que criticaban su subjetividad. Sin embargo, las exigencias del entorno, el clima, la tierra y la guerra ilustraron la utilidad del enfoque bayesiano, especialmente en situaciones en las que los recursos eran limitados y las decisiones urgentes. La flexibilidad del bayesianismo para manejar las incertidumbres demostró ser más eficaz que el enfoque frecuentista, más rígido pero igualmente valioso en otros ámbitos.

El legado de Jeffreys, Ramsey, Turing y otros pioneros que abrazaron la probabilidad subjetiva allanó el camino para una aceptación gradual más amplia del bayesianismo, especialmente en las situaciones ya mencionadas en este ensayo. El enfoque bayesiano ha demostrado que las probabilidades subjetivas a priori, aplicadas de forma adecuada y lógica, pueden ser una herramienta inestimable para dar forma y gestionar la incertidumbre en la ciencia y en la vida cotidiana, redefiniendo nuestra forma de abordar los problemas en un mundo bastante impredecible.

Y aunque este enfoque ofrece herramientas poderosas para navegar en momentos de incertidumbre, se enfrenta a un gran desafío. Nuestras propias limitaciones cognitivas y las trampas de nuestra intuición. Aunque los números y las probabilidades nos acercan a la verdad, nuestros cerebros procesan a menudo esta información de formas que contradicen la lógica.

NUESTRAS INTUICIONES A MENUDO NOS ENGAÑAN: CÓMO FALLA NUESTRA LÓGICA

Niño-niña

Chivers aborda un interesante problema de probabilidad conocido como la «paradoja niño-niña» para ilustrar cómo nuestras intuiciones pueden engañarnos, especialmente en situaciones que a primera vista parecen sencillas.

Consideremos el siguiente escenario. Un matemático tiene dos hijos y sabemos que al menos uno de ellos es varón. ¿Cuál es la probabilidad de que ambos hijos sean varones? Intuitivamente, muchos de nosotros podríamos pensar que la probabilidad es del 50%, dado que el segundo hijo podría ser tanto un niño como una niña. Sin embargo, la respuesta correcta es 1/3, aproximadamente el 33%.

¿A qué se debe esta discrepancia? Para entenderla, debemos considerar todas las posibles parejas de hijos que podría tener el matemático: niña-niña, niña-niño, niño-niña y niño-niño. Sabiendo que al menos uno de los hijos es un varón, descartamos la combinación niña-niña. Esto nos deja con tres configuraciones posibles, de las cuales solo una es niño-niño. Por lo tanto, la probabilidad es de 1/3.

Como dice Chivers, este resultado puede chocar con nuestra intuición, como si el conocimiento del sexo de un hijo tuviera un efecto sobre el sexo del otro. Sin embargo, es simplemente un reflejo de cómo interpretamos la información disponible. Curiosamente, si la información se ajustara para especificar que el hijo mayor es varón, la probabilidad de que ambos hijos sean varones salta al 50%, ya que solo quedarían dos opciones viables: niño-niño o niño-niña. Este tipo de escenario muestra cómo incluso pequeñas variaciones en la presentación de los datos pueden alterar drásticamente nuestras conclusiones.

El problema de Monty Hall

El problema de Monty Hall, un dilema clásico de probabilidad, demuestra cómo nuestras intuiciones pueden engañarnos, especialmente cuando se trata de tomar decisiones bajo incertidumbre. Este problema toma su nombre de un famoso concurso de televisión y plantea la siguiente situación.

Como concursantes, nos enfrentamos a tres puertas. Detrás de una hay un coche (el premio) y detrás de las otras dos, cabras. Imaginemos que elegimos la puerta número uno. Conociendo el contenido que hay detrás de cada una, el presentador abre otra puerta, la número tres, revelando una cabra. Entonces nos ofrece la opción de cambiar nuestra elección inicial por la puerta número dos. ¿Deberíamos hacerlo?

A menos que nos apetezca una cabra, la respuesta, sorprendentemente, es sí. Cambiar nuestra elección aumenta las probabilidades de ganar el coche de 1/3 a 2/3. ¿Por qué? Primero, porque al principio, al elegir la puerta uno, la probabilidad de que el coche esté ahí es de 1/3, mientras que hay una probabilidad de 2/3 de que esté detrás de cualquiera de las puertas. En segundo lugar, cuando el presentador abre la puerta tres, no altera la probabilidad inicial; sigue habiendo 1/3 de probabilidad de que el coche esté detrás de nuestra puerta y 2/3 de probabilidad de que esté detrás de la otra puerta (la puerta dos). Por último, cambiar de puerta nos da ventaja porque aprovechamos los 2/3 de probabilidad acumulados en las puertas que no elegimos inicialmente.

Esto contradice la intuición común, que sugeriría una probabilidad del 50% tras revelarse que una de las puertas es incorrecta.

Para entender mejor por qué es ventajoso cambiar, consideremos un escenario hipotético más extremo. Supongamos que hay un millón de puertas. Elegimos una y el presentador procede a abrir 999.998 puertas más, todas escondiendo cabras (ignorando, por supuesto, cómo se las arreglaron para meter tantas cabras en el estudio). Al quedar solo una puerta cerrada, aparte de la que elegimos inicialmente, ¿no parece más probable que el coche esté detrás de la única puerta que no elegimos y que el presentador evitó abrir deliberadamente?

La decisión óptima en el problema de Monty Hall es cambiar de puerta y la razón reside en el conocimiento previo del presentador. A diferencia de lo que podríamos pensar, el presentador siempre sabe lo que se esconde detrás de cada puerta y revela conscientemente una cabra. No se trata de una acción aleatoria. Es una pista deliberada que modifica las probabilidades a favor de cambiar la elección. Este enigma ha generado un amplio debate, incluso entre matemáticos profesionales, poniendo de relieve lo contraintuitivo que puede ser el razonamiento probabilístico.

Chivers señala que este dilema es un claro ejemplo del razonamiento bayesiano en acción: adaptamos nuestras creencias en respuesta a la nueva información. En el contexto del programa, el hecho de que el presentador abra una puerta no es un acontecimiento aleatorio, sino una pista crucial que debemos usar para recalibrar nuestras probabilidades. Es importante comprender que si el presentador actuara sin saber lo que hay detrás de las puertas o eligiera una al azar, la decisión de cambiar o no de puerta sería indiferente desde una perspectiva bayesiana, ya que abrir una puerta no añadiría información relevante.

Aunque nuestro cerebro está diseñado para procesar la información de forma bayesiana, a menudo no aplica esta lógica de forma intuitiva. Al igual que en la paradoja niño-niña y en el problema de Monty Hall nuestras intuiciones nos fallan, el razonamiento bayesiano interviene para darnos una forma de pensar que ayuda a nuestra intuición y se apoya en la lógica de dicho teorema.

LÓGICA EN EL TEOREMA DE BAYES

El bayesianismo es fundamental en el campo de la lógica, sobre todo cuando se trata de manejar probabilidades y actualizar creencias a partir de nueva información. A diferencia de la lógica clásica, que opera en un marco de valores binarios como unos y ceros, el teorema de Bayes ofrece un enfoque más dinámico y adaptativo.

La lógica clásica es indispensable para hacer funcionar los ordenadores y demostrar enunciados lógicos, pero se queda corta a la hora de evaluar probabilidades. Aquí es donde brilla el teorema de Bayes, que permite ajustar las creencias al recibir nueva información, un proceso esencial en la teoría de la decisión. Chivers da un ejemplo ilustrativo con una lotería estatal. (No soy muy brillante en estadística así que intentaré hacerlo lo mejor posible).

Imaginemos que nos enfrentamos a una lotería estatal en la que el objetivo es acertar seis números de setenta para ganar el gran premio. La probabilidad inicial, o probabilidad a priori, de acertar es de 1 entre 131.115.985, una probabilidad extremadamente baja. Supongamos ahora que disponemos de un dispositivo capaz de identificar la combinación ganadora. Este dispositivo emite un pitido cuando detecta los números correctos, pero tiene un defecto. También pita aleatoriamente cada cuatro veces, aunque los números sean incorrectos. Cada vez que pita, nos enfrentamos al dilema: ¿es una señal ganadora o solo un error?

Aquí es donde entra en juego el teorema de Bayes. Veamos cómo se aplica este razonamiento.

Primer paso: probabilidades iniciales (a priori). Antes de considerar el pitido del dispositivo, nuestra probabilidad de tener la combinación ganadora es, como vimos, de solo 1 entre 131.115.985.

Segundo paso: probabilidades con la evidencia (cociente de probabilidad). El pitido del aparato es nuestra nueva «evidencia», nueva información. Ahora sabemos que el pitido es correcto una de cada cuatro veces, lo que significa que es cuatro veces más probable oír un pitido si tenemos la combinación correcta que si es incorrecta. Aunque esta evidencia aumenta las probabilidades de que tengamos el boleto ganador, no nos aporta una certeza absoluta.

Tercer paso: cálculo de la probabilidad posterior. Usando el teorema de Bayes, multiplicamos nuestra probabilidad a priori por el cociente de probabilidad. Este cálculo nos da una probabilidad posterior de que el boleto sea ganador de 1 entre 32.778.996 después de oír el pitido. Aunque las probabilidades de que seamos los ganadores siguen siendo bajas, las mejoramos.

A continuación, repetimos el proceso para obtener una mayor certeza. Para aumentar la fiabilidad de nuestras conclusiones, necesitamos múltiples confirmaciones del pitido en el mismo boleto. Si el dispositivo emite un pitido consistente en repetidas ocasiones, nuestra confianza en la validez del boleto puede aumentar sustancialmente. Según Chivers, Eliezer Yudkowsky, un escritor estadounidense, afirma que necesitamos al menos catorce pitidos consistentes para tener una confianza razonable en que poseemos el boleto ganador. Sin esta repetición, la probabilidad de un falso positivo sigue siendo considerable. (Le planteé este problema a la IA o1-preview y sorprendentemente llegó a la misma conclusión. Según su razonamiento, se necesitan al menos catorce pitidos consecutivos para que la probabilidad posterior supere el 50%, y al menos dieciséis pitidos consecutivos para que supere el 90%).3

Como continúa diciendo el autor, el teorema de Bayes es a la estadística lo que el motor de Carnot es a la termodinámica (un modelo teórico de una máquina que convierte el calor en trabajo con la máxima eficacia posible). Ambos representan modelos teóricos ideales que, aunque no son perfectamente aplicables en la práctica, establecen un estándar al que podemos aspirar. En el caso del teorema de Bayes, nos ayuda a aproximarnos a la mejor decisión posible, aunque nuestras estimaciones de probabilidades y evidencias puedan ser imperfectas.

La teoría bayesiana puede hacer todo lo que hace la lógica deductiva clásica y más. Bayes nos permite no solo determinar si algo es verdadero o falso, sino también evaluar la probabilidad de que algo sea cierto. Esto nos capacita para tomar decisiones informadas basadas en probabilidades, expandiendo nuestra comprensión más allá del mero blanco y negro de la certeza hacia un espectro de grises lleno de matices y posibilidades.

Veamos ahora un escenario común en nuestra vida cotidiana que demuestra la utilidad del teorema de Bayes para actualizar nuestras creencias basándonos en las evidencias disponibles. (De nuevo, lo haré lo mejor que pueda).

Imaginemos que observamos 100 mañanas y queremos saber si ha llovido al ver las aceras mojadas. Sabemos que en nuestra ciudad llueve por la noche el 33% de las veces, es decir, 33 de esas 100 noches. Cuando llueve, las aceras están mojadas el 80% de las veces, lo que significa que, como el 80% de 33 es 26,4, aproximadamente 26 de esas 33 mañanas veremos aceras mojadas debido a la lluvia. Por otro lado, cuando no llueve, es decir, las otras 67 noches, digamos que los aspersores mojan las aceras el 20% de las veces. Esto ocurre unas 13 mañanas, porque el 20% de 67 (que son las noches que no llovió) es 13,4.

Sumando los dos casos, tenemos que las aceras están mojadas aproximadamente 39 mañanas de las 100 que observamos: 26 a causa de la lluvia y 13 a causa de los aspersores.

Ahora bien, si salimos de casa una mañana y vemos las aceras mojadas, queremos saber qué probabilidad hay de que haya llovido la noche anterior. Al principio, sin ninguna información adicional, sabemos que la probabilidad de lluvia es del 33%, porque llueve 33 de cada 100 noches. Pero si observamos las aceras mojadas, esta probabilidad cambia. De las 39 mañanas con aceras mojadas, 26 veces se debe a que llovió y 13 a los aspersores. Así pues, la probabilidad de que haya llovido dadas las aceras mojadas es de 26 entre 39, lo que equivale aproximadamente al 66%.

Esto significa que, al observar aceras mojadas, nuestras creencias se ajustan. Pasamos de pensar que hay un 33% de probabilidad de que haya llovido a un 66%. Y esta actualización es gracias al teorema de Bayes, que nos ayuda a combinar nuestra información inicial (la probabilidad de lluvia) con la nueva evidencia (las aceras mojadas) para obtener una probabilidad más exacta.

Para verlo más claro:

Información inicial: sabemos que llueve el 33% de las noches (33 de cada 100 noches).

Nueva evidencia: vemos las aceras mojadas.

Actualización de las creencias: teniendo en cuenta que las aceras pueden estar mojadas tanto por la lluvia como por los aspersores, calculamos que hay un 66% de probabilidad de que haya llovido cuando vemos aceras mojadas.

Nuestra confianza en que ha llovido se duplica al incorporar la nueva evidencia.

Se trata de otro ejemplo que ilustra cómo el teorema de Bayes nos permite calcular la probabilidad de sucesos pasados, como la lluvia durante la noche, basándonos en observaciones actuales, como las aceras mojadas. Usando tanto nuestras creencias previas (probabilidades a priori) como las nuevas evidencias, Bayes nos da una herramienta para estimar lo plausible que es una hipótesis, en este caso, que haya llovido, basándose en las evidencias disponibles.

Así pues, el teorema de Bayes no solo nos ayuda a ajustar nuestras creencias basándonos en nuevas evidencias, sino que también desempeña un papel crucial en la toma de decisiones en condiciones de incertidumbre. Proporciona un método para evaluar la verosimilitud de nuestras hipótesis que va más allá de lo que puede ofrecer la lógica clásica, facilitando una toma de decisiones más informada en el mundo y en nuestras vidas.

CÓMO USAMOS EL RAZONAMIENTO BAYESIANO EN NUESTRAS VIDAS

Del tiempo al tráfico

Todos los días, sin darnos cuenta, aplicamos los principios del razonamiento bayesiano a las decisiones cotidianas. Tomemos, por ejemplo, un cielo nublado por la mañana. Aunque no somos meteorólogos, la visión de las nubes nos lleva a pensar instintivamente que es más probable que llueva. Esta suposición no surge de la nada. Se basa en nuestra experiencia acumulada de que un cielo gris suele presagiar lluvia. Esto se hace en el bayesianismo.

Del mismo modo, al observar que son las cinco de la tarde, muchos de nosotros prevemos automáticamente un aumento del tráfico. Esta expectativa no depende de sortilegios o coincidencias, sino de un cálculo informado basado en la experiencia pasada: la hora pico habitual. También en este caso estamos aplicando intuitivamente el teorema de Bayes, ajustando nuestra expectativa de tráfico (la probabilidad P(A)) tras incorporar nueva información relevante, como la hora del día (B).

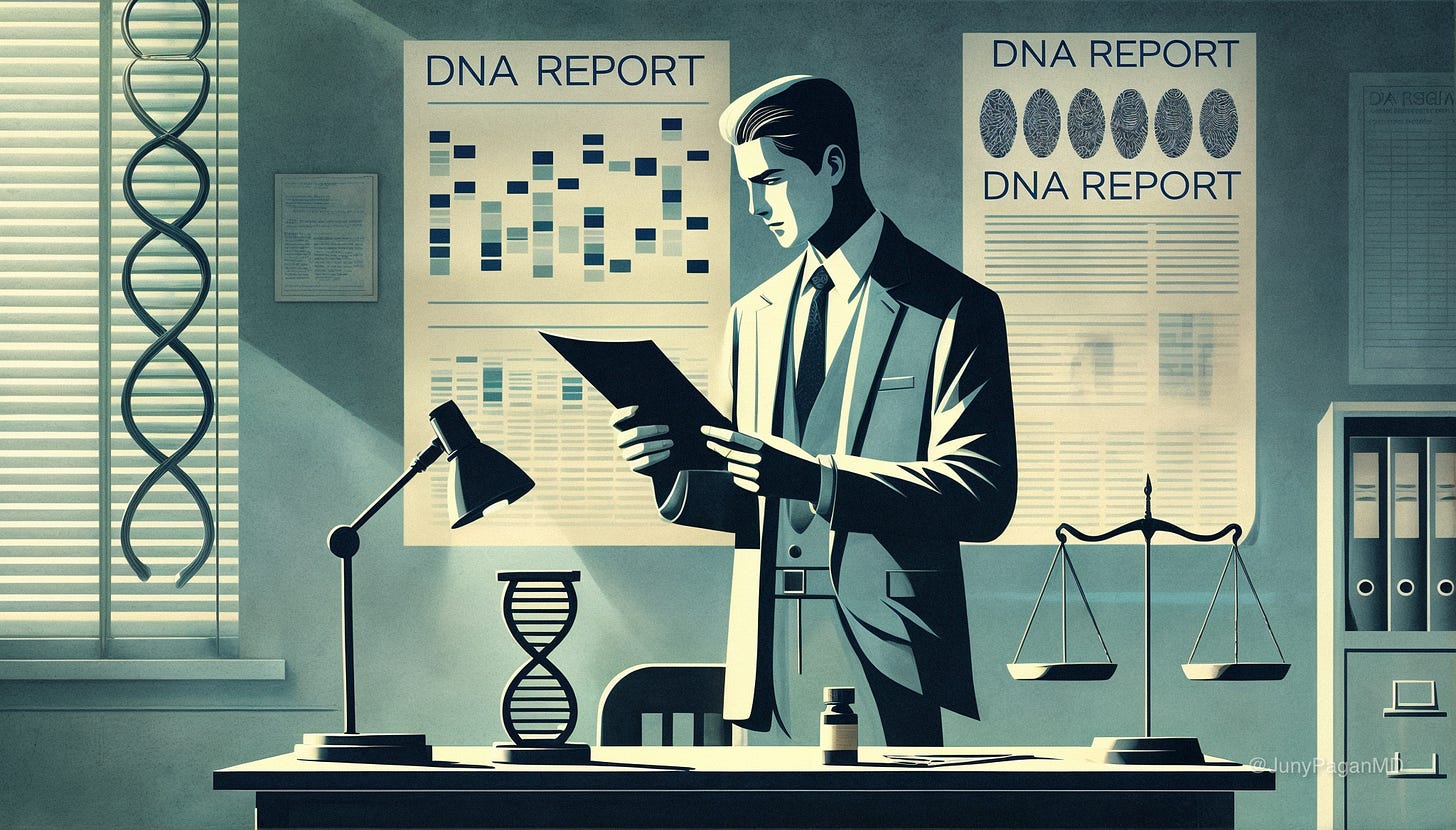

Derecho: la falacia del fiscal

Imaginemos un juicio en el que la pieza clave es una muestra de ADN encontrada en la escena del crimen que coincide con la del sospechoso. Un experto testifica que es extremadamente improbable que una persona inocente tenga ese ADN específico, tal vez uno entre tres millones (1/3.000.000). A primera vista, esto parece una evidencia irrefutable de su culpabilidad, ¿verdad? Pero esto sería un ejemplo clásico de lo que se conoce como la «falacia del fiscal».

Esta falacia se produce cuando se confunde la probabilidad de encontrar ciertas evidencias bajo el supuesto de inocencia con la probabilidad de que la persona sea inocente dado que se encontraron dichas evidencias. En otras palabras, uno piensa erróneamente: «es casi imposible que una persona inocente tenga este ADN, por lo que el sospechoso debe ser culpable». Pero este razonamiento es falaz.

Para entenderlo, supongamos que vivimos en una ciudad de tres millones de habitantes. Si la probabilidad de que una persona inocente tenga una coincidencia de ADN es de una entre tres millones, teóricamente, podría haber una persona en la ciudad cuyo ADN coincidiera por mera casualidad. Si basamos una acusación únicamente en la coincidencia de ADN, correríamos el riesgo de condenar a esta persona inocente simplemente porque su ADN coincide por casualidad, lo que sería injusto. Necesitamos más evidencias, como el motivo, la oportunidad o cualquier otra prueba que vincule al sospechoso con el delito.

El teorema de Bayes nos ofrece una valiosa herramienta en este contexto. Nos enseña a ajustar nuestras creencias en función de la nueva información. Este teorema nos insta a considerar la probabilidad previa de la culpabilidad del sospechoso antes del análisis de ADN, así como la probabilidad de obtener esa muestra de ADN tanto si el sospechoso es inocente como si es culpable. Gracias a esto, evitamos caer en la falacia del fiscal. Es bayesianismo.

Medicina: la importancia de la probabilidad a priori

Supongamos que nos enfrentamos al problema de diagnosticar una enfermedad rara. Al igual que un detective que reúne pistas para resolver un misterio, en la mayoría de los casos los médicos no suelen basarse en un único síntoma o resultado de una prueba para confirmar su diagnóstico. En su lugar, usan una serie de evidencias y acumulan información de múltiples fuentes para aumentar la certeza de su diagnóstico.

Este proceso es un claro ejemplo de razonamiento bayesiano en acción. Inicialmente, la probabilidad de que un paciente padezca una enfermedad tan rara puede ser muy baja (probabilidad a priori). Un solo síntoma o una sola prueba pueden alterar ligeramente esta probabilidad, pero no son suficientes para establecer un diagnóstico. Sin embargo, a medida que se acumulan más síntomas y resultados de pruebas que coinciden con el perfil de la enfermedad, la probabilidad de un diagnóstico correcto aumenta significativamente.

Pasemos ahora a otro escenario con el que podemos identificarnos más. Imaginemos que nos sometemos a una prueba médica para detectar una enfermedad y el resultado es positivo. La prueba afirma tener una precisión del 99%. A primera vista, podríamos pensar que existe una probabilidad del 99% de padecer realmente la enfermedad, pero esta interpretación no capta toda la historia.

Para entender realmente lo que significa ese resultado positivo, debemos considerar la probabilidad inicial, la probabilidad a priori, de tener la enfermedad antes de la prueba. Supongamos que, en la población general, la enfermedad solo afecta al 1%. Recordemos que la prueba tiene una precisión del 99%. Si realizamos esta prueba a 1.000 personas, de las cuales 100 tienen realmente la enfermedad (1%), la prueba detectará correctamente a 99 de esas personas. Pero de las 9.900 personas que no tienen la enfermedad, aproximadamente 99 (1%) también recibirán un resultado positivo, porque la precisión de la prueba es del 99%. Al final, de los 198 resultados positivos (99 verdaderos y 99 falsos), solo la mitad (99) corresponden a personas realmente enfermas.

Reduzcamos el número un poco. Si se somete a la prueba a 100 personas, es probable que 1 tenga la enfermedad y, dada la gran precisión de la prueba, es muy probable que el resultado sea positivo. Sin embargo, también es probable que de las 99 personas restantes, que no tienen la enfermedad, 1 reciba un resultado falso positivo debido a la misma tasa de precisión. Esto significa que, de dos resultados positivos, solo uno es verdadero. En nuestro caso, si nuestra prueba es positiva, la probabilidad de tener la enfermedad es, de hecho, del 50% y no del 99%, como creeríamos en un principio.

Esto es un típico malentendido que muchos de nosotros tenemos al interpretar los resultados de las pruebas médicas, y refleja la importancia del razonamiento bayesiano. Comprender la precisión de una prueba es solo una parte del rompecabezas. La clave para una interpretación completa y precisa también incluye conocer la probabilidad a priori de la condición en cuestión. Esto es bayesianismo.

Inteligencia artificial: máquinas bayesianas

En el mundo de la inteligencia artificial (IA), las máquinas aprenden y adaptan sus respuestas de formas que recuerdan sorprendentemente al funcionamiento del cerebro humano. Consideremos las redes neuronales, compuestas por innumerables «neuronas» interconectadas. Estas conexiones se refuerzan o debilitan a medida que la máquina aprende, de forma similar a como nosotros ajustamos nuestras propias conexiones neuronales en función de las experiencias.

Para enseñar a una IA, en concreto a los modelos de lenguaje a gran escala (LLM), a escribir como los humanos, se emplea un proceso conocido como preentrenamiento. Durante esta fase, la IA se expone a grandes cantidades de texto extraído de libros, páginas web y documentos digitales. Este método de aprendizaje es no supervisado, lo que significa que la IA aprende por sí misma a identificar y comprender patrones lingüísticos sin necesidad de datos específicamente etiquetados que la guíen. Durante el preentrenamiento, la IA ajusta lo que se conoce como «ponderaciones», que son reglas matemáticas complejas que determinan la probabilidad de que ciertas palabras o frases aparezcan juntas o en un orden concreto. Estos ajustes son fundamentales para que la IA pueda imitar la forma en que los humanos usamos el lenguaje.

Aunque las IA modernas no usan exactamente los cálculos prescritos por el bayesianismo —principalmente porque sería demasiado lento— el principio subyacente es el mismo. El enfoque bayesiano también se observa en las IA diseñadas para tareas como el reconocimiento de imágenes. Tomemos, por ejemplo, una IA que debe discernir si una fotografía muestra un gato o un perro. Usa imágenes de entrenamiento anteriores como datos de base y ajusta continuamente sus «creencias» con cada nueva información que recibe, optimizando su capacidad para hacer la distinción correcta.

Y como hemos visto, al igual que en los modelos bayesianos, estos algoritmos de aprendizaje automático usan estas grandes cantidades de datos para ajustar las probabilidades iniciales, o probabilidades a priori, algo que reduce la dependencia de suposiciones individuales y se basa más en patrones observados en los datos reales. Tal ajuste continuo permite a la IA no solo mejorar su precisión, sino también mantener la capacidad de incorporar nueva información de forma flexible. Esta es una de las principales ventajas de los enfoques bayesianos en el aprendizaje automático: su capacidad para adaptarse y evolucionar a medida que se procesa más información.

Esta metodología es análoga a la forma en que nuestro cerebro procesa la probabilidad de lluvia al observar las nubes en el cielo. Así, la IA, al igual que nosotros, usa el razonamiento basado en la acumulación y actualización de conocimientos para hacer predicciones y tomar decisiones basadas en sus «creencias» previas.

CREENCIAS

El teorema de Bayes permite comprender por qué la gente no suele cambiar de opinión ni siquiera ante evidencias convincentes.

Este principio matemático ilustra cómo nuestras creencias preexistentes —nuestras probabilidades a priori— determinan la interpretación de la nueva información. Por ejemplo, una persona convencida de que las vacunas no son seguras es probable que interprete cualquier evidencia a favor de su seguridad como poco convincente. Esto no refleja necesariamente una falta de racionalidad. Más bien, la persona está ajustando sus creencias actuales basándose en su sistema de creencias establecido.

Este mecanismo es precisamente lo que hace que las teorías de la conspiración y otras creencias profundamente arraigadas sean tan resistentes al cambio, incluso ante nueva información contradictoria. Si la predisposición de alguien a aceptar nuevos datos es muy baja, es probable que sus opiniones originales persistan.

Chefs y políticos malos

Nuestras creencias actúan a menudo como predicciones sobre cómo vemos y entendemos el mundo que nos rodea.

Un punto crucial planteado por el autor es que cuando debatimos temas controvertidos, como la cultura de la cancelación, generalmente estamos de acuerdo en los hechos subyacentes, por ejemplo, que algunas personas han sido despedidas por comentarios realizados en línea. Sin embargo, el conflicto surge cuando intentamos etiquetar estos hechos. Pero, ¿qué ganamos realmente con estas etiquetas? Una pregunta que el autor sugiere que nos hagamos es que si cambiamos nuestra opinión sobre esta cuestión, ¿afectaría a nuestras predicciones o expectativas futuras? Si la respuesta es negativa, entonces probablemente estemos debatiendo sobre semántica más que sobre sustancia. Este tipo de debate abunda en la vida cotidiana. Nos enredamos las etiquetas. Y a menudo, estas discusiones sobre etiquetas no cambian la realidad de las situaciones que intentamos describir. Sería mucho más productivo centrarse en los hechos concretos y palpables que en las palabras que usamos para describirlos.

Ahora, centrándose en los hechos, Chivers profundiza en cómo nuestro sistema de decisión bayesiano influye en nuestras creencias, especialmente cuando se trata de confirmarlas. Sostiene que cualquier evidencia que busquemos para apoyar una creencia debería, idealmente, tener el potencial de reforzarla o debilitarla.

La falta de evidencia esperada también desempeña un papel crucial en este proceso. Tomemos un ejemplo ilustrativo. Imaginemos que desconfiamos de un chef de renombre, creyendo firmemente que no es tan honesto como dice ser, sobre todo cuando se trata de la calidad de los ingredientes que usa. A pesar de su reputación como defensor de lo orgánico y lo fresco, sospechamos que sus platos no cumplen los estándares que promociona. Movidos por estas dudas, decidimos investigar más a fondo, por ejemplo, explorando las reseñas de su restaurante y, si es posible, visitando el establecimiento para evaluar la calidad de los ingredientes.

Si durante nuestra investigación encontramos múltiples comentarios de clientes sobre el uso de ingredientes de baja calidad, o si observamos directamente prácticas que consideramos engañosas, esta evidencia podría reforzar nuestra creencia en la falta de honradez del chef. Por el contrario, si nuestras búsquedas resultan infructuosas y, en cambio, todo indica que los ingredientes son efectivamente de alta calidad y consistentes con lo que él anuncia, este hallazgo debería hacernos reconsiderar nuestras sospechas iniciales. La ausencia de evidencias en lugares donde esperábamos encontrarlas debería sorprendernos lo suficiente como para cuestionar la validez de nuestras creencias previas.

El ejemplo que nos ofrece Chivers es que si estamos convencidos de que un político es corrupto y creemos que ha cometido actos atroces, como torturar cachorros, podríamos, por ejemplo, visitar su página web en busca de evidencias de tales actos. Según Chivers, la presencia o ausencia de pruebas debería influir significativamente en nuestra opinión sobre el político. Si encontramos lo que cabría esperar, nuestra creencia se ve reforzada. Sin embargo, la ausencia de tales evidencias, especialmente si las consideramos altamente probables (digamos, un 95% de certeza), debería hacernos reconsiderar nuestra postura de forma significativa. También en este caso, la falta de evidencias donde esperábamos encontrarlas debería ser una sorpresa lo suficientemente grande como para hacernos cuestionar nuestras creencias iniciales.

Este principio se aplica no solo a los chefs y a los políticos, sino a muchas otras creencias, como la existencia de hadas madrinas. Si somos escépticos sobre ellas, cada día que pasa sin ver una refuerza nuestra creencia en su inexistencia. Pero, si de repente apareciera una —una de verdad, no una ilusión—, tendríamos que ajustar drásticamente nuestra creencia.

Chivers concluye que no somos racionales cuando no ajustamos nuestras creencias en ausencia de la evidencia esperada. Ignorar esta falta de evidencia, cuando teníamos claras expectativas de encontrarla, indica que no estamos empleando correctamente la información disponible para calibrar nuestras creencias de forma eficaz.

Sin embargo, hay un grupo de personas que consiguen ajustar sus perspectivas de forma constante y muy precisa, reevaluando sus creencias con cada nueva información. Este enfoque gradual y bayesiano de la certeza es el secreto de quienes sobresalen en el arte de predecir el futuro: los superpronosticadores.

SUPERPRONOSTICADORES: CÓMO PREDECIR EL FUTURO

Philip Tetlock, politólogo, pasó años estudiando la capacidad de las personas para predecir acontecimientos significativos en el mundo. Sus hallazgos desafiaron las expectativas. Aunque cabría suponer que los expertos en política y asuntos internacionales tendrían un alto grado de precisión, Tetlock descubrió que sus predicciones eran solo ligeramente mejores que las de alguien que elige respuestas al azar. De hecho, los describió como si lo hicieran poco mejor que un chimpancé lanzando dardos a una diana.

Sin embargo, Tetlock identificó un pequeño grupo que superaba sistemáticamente a los demás en la precisión de sus predicciones. Llamó a este grupo los «superpronosticadores». Estos individuos no destacaban necesariamente por su excepcional formación académica o experiencia profesional, ya que muchos eran aficionados con acceso únicamente a Internet y a herramientas comunes. Pero, como veremos, poseían una gran capacidad para anticipar acontecimientos futuros.

En un torneo de predicción en el que participaron varios equipos, los superpronosticadores no solo superaron a expertos, académicos de universidades de renombre y analistas con años de experiencia, incluidos algunos de la CIA, sino que los eclipsaron por unos márgenes impresionantes de hasta el 70%. Su éxito fue tan abrumador que, tras solo dos años, los organizadores decidieron cancelar el torneo, ya que los resultados de estos superpronosticadores habían dejado poco margen para comparaciones más significativas.

Lo que diferenciaba a los superpronosticadores no era solo su capacidad para pronosticar acontecimientos, sino cómo gestionaban la información. Eran maestros del ajuste constante. Revisaban y modificaban sus predicciones en respuesta a la nueva información o al surgimiento de dudas sobre sus estimaciones iniciales. Este enfoque de ajustes incrementales es una aplicación práctica del razonamiento bayesiano. Algunos de ellos llegaron a revisar sus previsiones docenas de veces, refinándolas poco a poco para acercarse lo más posible a la exactitud.

Los superpronosticadores destacan en el arte de la previsión por su capacidad para equilibrar la información general con los detalles específicos, un proceso que refleja el corazón del razonamiento bayesiano. Tomemos, por ejemplo, la cuestión de si un matrimonio recientemente celebrado durará. Un superpronosticador no se dejaría llevar únicamente por la aparente felicidad de la pareja en su boda. Empezaría su análisis considerando la tasa global de divorcios, la «tasa principal» o «visión exterior», y luego ajustaría esta probabilidad con observaciones específicas sobre la pareja y la boda, la «visión interior».

Una técnica que emplean estos expertos en predicción consiste en descomponer los problemas grandes y complejos en componentes más pequeños y manejables, un enfoque conocido como «método Fermi», en honor al físico Enrico Fermi. Chivers nos pide que imaginemos que queremos estimar cuántos afinadores de pianos hay en Chicago. Los superpronosticadores empezarían por considerar, por ejemplo, cuántas personas viven en la ciudad, cuántas de ellas es probable que posean un piano, con qué frecuencia hay que afinar estos instrumentos y cuánto tiempo se tarda en afinar uno. Esta descomposición y agregación de estimaciones más pequeñas permite que los errores se compensen entre sí, dando lugar a una conclusión sorprendentemente precisa.

Además de su meticulosidad en el análisis, los superpronosticadores son expertos en aprender tanto de sus errores como de los aciertos de los demás. Evalúan críticamente las predicciones de otros expertos, prestando especial atención a aquellos con un historial probado de precisión. También mantienen registros meticulosos de sus propias predicciones para revisar su precisión a lo largo del tiempo, lo que les permite perfeccionar continuamente sus técnicas.

Chivers subraya la importancia de pensar en términos de probabilidades y no de certezas absolutas. En lugar de considerar que algo definitivamente «ocurrirá o no», los superpronosticadores asignan porcentajes de probabilidad a sus predicciones, mostrando una comprensión matizada de la incertidumbre. Este enfoque mejora la precisión de sus predicciones y los convierte en modelos de cómo enfocar la toma de decisiones y el análisis de riesgos en cualquier ámbito de la vida.

Muchos de nosotros mantenemos opiniones rígidas sobre cuestiones cruciales como la política o la moral. Julia Galef, en su libro The Scout Mindset (2021), relata cómo Jerry Taylor, un conocido escéptico del cambio climático, empezó a cuestionarse sus propias creencias después de que un debate le instruyera a revisar datos fundamentales. Al descubrir manipulaciones en la información que había aceptado como cierta, Taylor profundizó en la investigación y detectó varios errores en la narrativa que había defendido. Aunque este cambio fue un desafío y le llevó tiempo, su persistencia en revisar y ajustar sus creencias fue erosionando su confianza en sus creencias anteriores.

Según Galef, cambiar de opinión, aunque pueda parecer mentalmente agotador, es en realidad menos estresante que aferrarse a creencias inflexibles. Mantener una creencia absoluta requiere descartar constantemente cualquier evidencia contraria para proteger la propia perspectiva, un proceso que puede resultar emocionalmente agotador. Imaginemos que Harold Jeffreys, el geólogo que demostró que el núcleo de la Tierra es líquido y su manto exterior es roca silícea, se hubiera aferrado a sus ideas iniciales y rechazado las evidencias que condujeron a su descubrimiento. O consideremos si Alan Turing se hubiera cerrado a reconsiderar sus hipótesis y nunca hubiera descifrado los códigos de la máquina Enigma. La historia, probablemente, habría sido diferente.